您正在查看9.2 -版本的RapidMiner Radoop文档点击这里查看最新版本

日志记录和监控

在客户端机器和集群上的日志中可以找到关于RapidMiner Radoop进程的许多有用信息。其中大多数都可以通过web界面访问。这个部分描述了最重要的日志的位置,并帮助您访问集群的web界面。

RapidMiner Studio和RapidMiner Server都创建日志文件,这些文件和其他信息一起保存错误,以便更容易诊断。通常,RapidMiner Support会请求这些文件来帮助排除故障。的提取日志选项是收集和共享日志以进行故障排除的简单方法。

提取日志操作

的![]() 提取日志行动上的管理Radoop连接窗口。提取日志将收集有关连接测试结果的所有详细信息并将它们打包到一个zip文件中。在将连接条目和日志打包之前,将从它们中删除密码和其他敏感细节。稍后可以提交此zip文件以支持故障排除。

提取日志行动上的管理Radoop连接窗口。提取日志将收集有关连接测试结果的所有详细信息并将它们打包到一个zip文件中。在将连接条目和日志打包之前,将从它们中删除密码和其他敏感细节。稍后可以提交此zip文件以支持故障排除。

收集的日志文件列表:

connection_entry.xml:您当前显示的Radoop连接条目。其中不包括Hive和Kerberos密码。connection_test_log4j.log:上次连接测试Hadoop通信的log4j日志。connection_test_logpanel.log:连接测试日志面板的内容。hadoop_properties.log的输出。设置- v调用您的集群。其中不包括Hive和Kerberos密码。rapidminer-studio.log: RapidMiner Studio的日志文件,默认保存在用户的。RapidMiner文件夹中。rm_preferences.cfg: RapidMiner Studio的首选项设置。rm_version.cfg:在RapidMiner Studio中安装的扩展及其版本。studio_log_panel.log:在FINEST级别的RapidMiner Studio日志面板的内容。test_setup.cfg:启用的集成测试及其超时。< TESTNAME > _ < applicationId > . log:集成测试期间执行的应用程序的日志。如果由于某种原因无法收集应用程序日志,则跳过它。

在哪里可以找到日志文件

有时需要检查单独的日志文件以进行故障排除。本节将介绍最重要的客户端和集群端日志。

RapidMiner Studio日志文件

RapidMiner Studio将日志保存在.RapidMiner用户主目录的子目录。在那里,你可以找到主日志文件,rapidminer-studio.log.如果你有问题开始RapidMiner,检查launcher.log有关启动过程的更多信息。

RapidMiner服务器日志文件

RapidMiner Server保存日志<安装目录> \独立\日志.默认情况下,服务器每天记录所有活动和更改文件。如果服务器被大量使用,这些文件可能会变得相当大。如果要向Support发送日志文件,最好不要发送整个文件。相反,应该只选择并发送相关的部分,例如在每行开头使用时间戳来标识要发送的行。

RapidMiner Studio日志面板

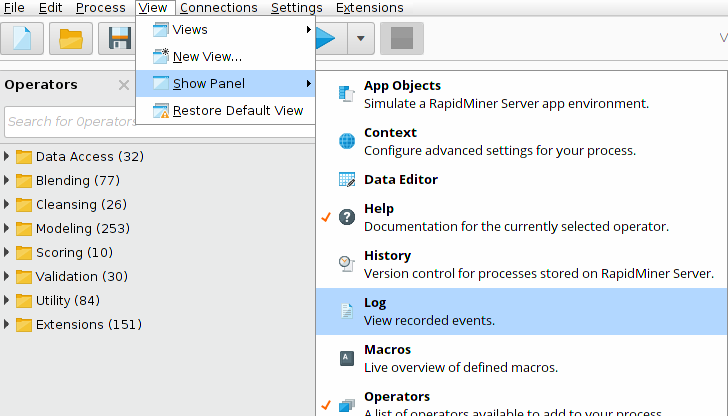

RapidMiner Radoop记录了许多有用的信息,包括生成的Hive查询日志面板。默认情况下,这个面板隐藏在RapidMiner Studio中,但强烈建议在使用RapidMiner Radoop时打开它。你可以打开日志面板通过选择查看> Show Panel > Log在RapidMiner Studio菜单中。

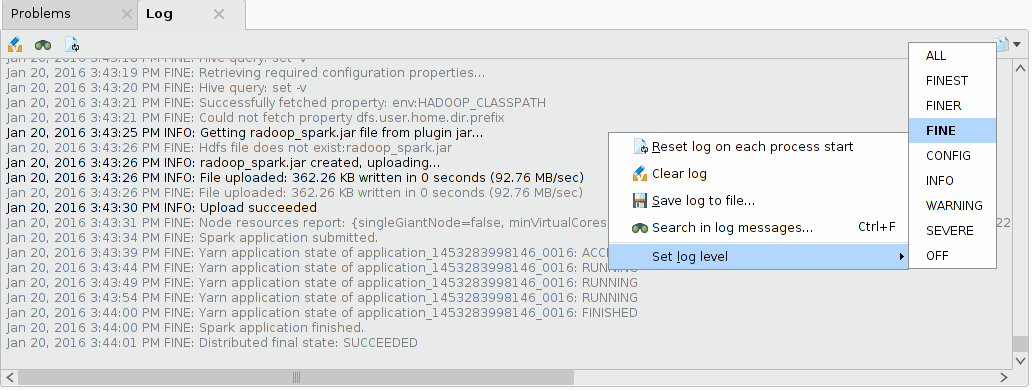

要查看Radoop的Hive查询,需要将日志级别设置为FINE。可以通过右键单击日志面板并选择设置日志级别>为FINE.

如果您有关于Radoop过程的故障排除问题,请包括日志面板内容在你的问题上的RapidMiner支持门户.

为RapidMiner启用log4j日志记录

Hadoop库使用log4j记录详细信息,这可能有助于解决通信和连接设置问题。请注意,log4j日志只包含Hadoop通信的信息,不包含Hive通信的信息。

的日志记录可以启用log4j设置/首选项菜单项。导航到Radoop页,并设置启用Log4j日志记录财产真正的.默认情况下,日志文件创建在RapidMiner用户目录称为radoop_log4j.log.如果要覆盖默认日志记录设置,请设置Log4j属性文件属性设置为有效的log4j . properties文件。

应用程序日志

每个MapReduce和Spark作业都在运行时创建日志。如果您的集群被配置为保存日志文件,则可以在作业完成后访问它们。设置yarn.nodemanager.delete.debug-delay-sec属性设置为较高的数字(例如10000),以保存已完成作业的日志。

Application Master日志可以在YARN上找到资源管理器界面,选择Cluster > Applications菜单。您可以通过检查应用程序的名称(它是相应的Radoop操作符的名称)和FinalStatus(如果您的进程没有成功完成,则查找FAILED状态)来确定您正在寻找的作业。如果您找到了正在查找的应用程序,请单击ID(类似于application_1430386217152_0015)并打开日志链接。

RapidMiner Radoop为一些操作员提供聚合日志收集,比如读CSV而且火花脚本.这对于调查失败的MapReduce或Spark作业特别有用。聚合的日志收集需要yarn.log-aggregation-enable = true,yarn.nodemanager.remote-app-log-dir和yarn.nodemanager.remote-app-log-dir-suffix设置在集群上。请注意,对于Impala连接,最后两个属性必须作为高级Hadoop设置手动提供。该特性的超时时间可以在首选项页面。

蜂巢日志

有些问题的原因可以通过打开Hive Server日志来确定。您可以通过集群管理界面(例如Cloudera Manager)访问此日志。但是,不能总是远程访问日志。您可能需要SSH进入集群并搜索Hive日志文件。Hive日志的位置和名称可能因每个发行版和Hive版本而不同。在CDH5上是这样的/var/log/hive/hive-server2.log默认情况下。还要注意Hive可能会启动所谓的当地的Hive任务来完成简单的本地任务。这些任务可以在任何节点上运行,它们的日志文件可能驻留在本地/ tmp /或/ tmp /蜂巢默认情况下,目录位于特定节点的文件系统上。某些错误的详情(MapredLocalTask错误)可能只在这些任务特定的日志文件中可用。

Hive查询日志被收集并显示在RapidMiner Studio日志面板中,以防出现错误。该特性需要Hive 0.14或更新版本。为了能检索到蜂巢的日志,hive.server2.logging.operation.enabled = true属性必须在集群上设置—这是CDH和HDP集群的默认行为。

方法可以更改日志记录级别hive.server2.logging.operation.level =详细财产。它可以设置在连接设置对话框作为高级Hive参数。请注意,这只适用于Hive 1.2或更新版本。

资源管理器和节点管理器日志

如果要访问资源管理器或节点管理器的日志,需要在“Tools > Local logs”路径下资源管理器监控页面。寻找名称类似于yarn-yarn-nodemanager——(域名). log而且yarn-yarn-resourcemanager——(域名). log.

RapidMiner Radoop使用强大的Hadoop数据视图,一个易于使用的图形化工具,用于:

- Hive和Impala数据库对象的管理、导入和查询

- 检查任意数据样本

- 开发Hive和Impala脚本,可以集成到RapidMiner Radoop流程中。

您可以使用web浏览器监视Hadoop集群的NameNode和ResourceManager。

NameNode监控

NameNode监控页面包含关于集群状态、运行状况和版本的信息,并提供对日志和HDFS文件系统的访问。默认情况下,它可以通过以下URL访问:

http:// < namenode_address >: 50070ResourceManager监控

ResourceManager是Hadoop中的服务,它在系统中所有应用程序之间仲裁资源。乐鱼体育安装ResourceManager管理页面提供了集群中运行的应用程序和作业的详细信息。在该界面可以查看执行RapidMiner Radoop进程任务的MapReduce任务的日志和信息。默认情况下,可以通过以下URL访问管理页面:

http:// < resource_manager_address >: 8088通过Spark UI监控Spark应用

可以通过Spark web界面跟踪Spark应用程序。默认情况下,它在端口4040(或4041、4042等)上自动启动。Spark UI非常有用,例如检查正在运行的Spark操作员的进度,或者检查Spark主和执行器的日志。要导航到Spark UI,请打开资源管理器界面,并选择指向正在运行的Spark作业的应用程序主程序的链接。URL应该如下所示:

http:// < resource_manager_address >: 8088 /代理/ < application_id >