您正在查看9.4 -版本的RapidMiner Radoop文档点击这里查看最新版本

日志记录和监控

关于RapidMiner Radoop进程的许多有用信息可以在客户端机器和集群的日志中找到。它们中的大多数都可以通过web界面访问。本节描述了最重要的日志的位置,并帮助您访问集群的web界面。

RapidMiner Studio和RapidMiner Server都创建日志文件,除了其他信息外,日志文件还保存错误,以便于诊断。通常,RapidMiner Support将请求这些文件以帮助进行故障排除。的提取日志选项是收集和共享日志以进行故障排除的一种简单方法。

提取日志操作

的![]() 提取日志采取行动管理Radoop连接窗口。提取日志将收集有关连接测试结果的所有详细信息,并将它们打包到一个zip文件中。在打包之前,密码和其他敏感细节将从连接条目和日志中删除。稍后可以将此zip文件提交给支持以进行故障排除。

提取日志采取行动管理Radoop连接窗口。提取日志将收集有关连接测试结果的所有详细信息,并将它们打包到一个zip文件中。在打包之前,密码和其他敏感细节将从连接条目和日志中删除。稍后可以将此zip文件提交给支持以进行故障排除。

收集到的日志文件列表:

connection_entry.xml当前显示的Radoop连接项。Hive和Kerberos密码不包括在内。connection_test_log4j.log:上次Connection Test中Hadoop通信的log4j日志。connection_test_logpanel.log:连接测试日志面板的内容。hadoop_properties.log:的输出设置- v调用您的集群。Hive和Kerberos密码不包括在内。rapidminer-studio.log: RapidMiner Studio的日志文件,默认存储在用户的.RapidMiner文件夹中。rm_preferences.cfg: RapidMiner Studio的首选项设置。rm_version.cfg: RapidMiner Studio中安装的扩展及其版本。studio_log_panel.log: RapidMiner Studio Log Panel在FINEST级别上的内容。test_setup.cfg:启用的集成测试及其超时。< TESTNAME > _ < applicationId > . log:集成测试期间执行的应用程序的日志。如果由于任何原因无法收集应用程序日志,则跳过该日志。

在哪里可以找到日志文件

有时需要检查单独的日志文件以进行故障排除。本节将介绍最重要的客户端和集群端日志。

RapidMiner Studio日志文件

文件中保存日志.RapidMiner用户主目录的子目录。在那里,您可以找到主日志文件,rapidminer-studio.log.如果你有问题开始RapidMiner,检查launcher.log有关启动过程的其他信息。

RapidMiner服务器日志文件

RapidMiner服务器保存登录信息<安装目录> \独立\日志.默认情况下,服务器每天记录所有活动和更改文件。如果服务器被大量使用,这些文件可能会变得相当大。如果要向支持部门发送日志文件,最好不要发送整个文件。相反,只选择和发送相关的部分,例如,使用每行开头的时间戳来标识要发送的行。

RapidMiner Studio日志面板

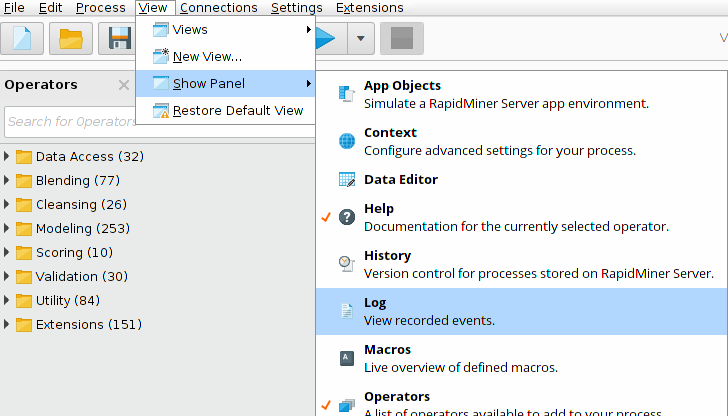

RapidMiner Radoop记录了许多有用的信息,包括生成的Hive查询日志面板。默认情况下,该面板隐藏在RapidMiner Studio中,但强烈建议在使用RapidMiner Radoop时打开它。你可以打开日志选择面板查看>显示面板>日志在RapidMiner Studio菜单中。

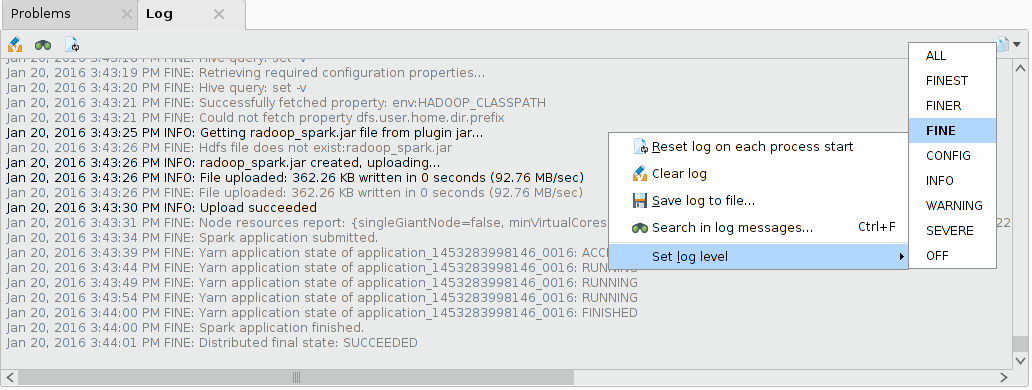

要查看Radoop的Hive查询,需要将日志级别设置为FINE。控件中的右键单击即可日志面板和选择设置日志级别> FINE.

如果您有关于Radoop进程的故障排除问题,请包含日志关于RapidMiner的问题中的面板内容支持门户.

为RapidMiner启用log4j日志记录

Hadoop库使用log4j记录详细信息,这可能有助于解决通信和连接设置问题。请注意,log4j日志中只包含Hadoop通信信息,不包含Hive通信信息。

log4j日志记录可以在设置/首选项菜单项。导航到Radoop页并设置启用Log4j日志财产真正的.默认情况下,日志文件是在RapidMiner用户目录下创建的radoop_log4j.log.如果要覆盖默认日志记录设置,请设置Log4j属性文件属性设置为有效的log4j . properties文件。

应用程序日志

每个MapReduce和Spark作业都会在运行时创建日志。如果您的集群配置为保留日志文件,则在作业完成后可以访问它们。设置yarn.nodemanager.delete.debug-delay-sec属性设置为较大的数字(例如10000),以保留已完成作业的日志。

Application Master日志可以在YARN上找到资源管理器界面,选择“Cluster > Applications”菜单。您可以通过检查应用程序的Name(它是相应的Radoop操作符的名称)和FinalStatus(如果您的进程没有成功完成,则查找FAILED状态)来确定正在查找的作业。如果找到了要查找的应用程序,单击ID(类似于application_1430386217152_0015)并打开日志链接。

RapidMiner Radoop为一些操作提供了聚合日志收集,比如读CSV和火花脚本.这对于调查失败的MapReduce或Spark作业特别有用。聚合的日志收集需要yarn.log-aggregation-enable = true,yarn.nodemanager.remote-app-log-dir和yarn.nodemanager.remote-app-log-dir-suffix在集群上设置。请注意,对于Impala连接,最后两个属性必须作为高级Hadoop设置手动提供。该特性的超时时间可以在首选项页面。

蜂巢日志

一些问题的原因可以通过打开Hive Server日志来识别。您可以通过群集管理接口(例如Cloudera Manager)访问此日志。但是,不能总是远程访问日志。您可能需要SSH到集群中搜索Hive日志文件。Hive日志的位置和名称可能因发行版和Hive版本而异。在CDH5上是/var/log/hive/hive-server2.log默认情况下。还要注意Hive可能会启动所谓的当地的Hive任务来完成简单的本地任务。这些任务可以在任何节点上运行,它们的日志文件可以驻留在本地/ tmp /或/ tmp /蜂巢默认情况下,特定节点的文件系统上的目录。某些错误的详情(MapredLocalTask错误)可能仅在这些任务特定的日志文件中可用。

Hive的查询日志会被收集并显示在RapidMiner Studio的日志面板中,以防出错。此功能需要Hive 0.14或更新版本。为了能找回蜂巢的日志hive.server2.logging.operation.enabled = true属性必须在集群上设置—这是CDH和HDP集群的默认行为。

日志级别可以使用hive.server2.logging.operation.level =详细财产。它可以设置在连接设置对话框作为高级Hive参数。请注意,这只适用于Hive 1.2或更新版本。

资源管理器和节点管理器日志

如果您需要访问“资源管理器”或“节点管理器”的日志,则需要在浏览器的“工具>本地日志”中访问资源管理器监控页面。查找名称如下的日志yarn-yarn-nodemanager——(域名). log和yarn-yarn-resourcemanager——(域名). log.

RapidMiner Radoop使用强大的Hadoop数据视图,一个易于使用的图形工具,用于:

- Hive和Impala数据库对象的管理、导入和查询

- 检查任意数据样本

- 开发可以集成到RapidMiner Radoop进程中的Hive和Impala脚本。

您可以通过web浏览器监控Hadoop集群的NameNode和ResourceManager。

NameNode监控

NameNode监控页面包含集群的状态、健康和版本信息,并提供对日志和HDFS文件系统的访问。默认情况下,它可以通过以下URL访问:

http:// < namenode_address >: 50070ResourceManager监控

ResourceManager是Hadoop中的服务,用于在系统中所有应用程序之间仲裁资源。乐鱼体育安装ResourceManager管理页面提供集群中运行的应用程序和作业的详细信息。在该界面中,您可以查看执行RapidMiner Radoop进程任务的MapReduce作业的日志和信息。默认情况下,可以通过以下URL访问管理页面:

http:// < resource_manager_address >: 8088通过Spark界面监控Spark应用

Spark应用程序可以通过Spark web UI进行跟踪。默认情况下,它会在端口4040(或4041、4042等)上自动启动。Spark UI非常有用,例如检查正在运行的Spark操作程序的进度,或者检查Spark的主日志和执行日志。要导航到Spark UI,打开资源管理器界面并选择到正在运行的Spark作业的Application Master的链接。URL应该如下所示:

http:// < resource_manager_address >: 8088 /代理/ < application_id >